كل ما تحتاج معرفته عن تقييم نماذج اللغة الكبيرة (LLM) - المعايير ولوحات التصنيف

دليلك العملي لفهم اختبارات الأداء والمقارنات البشرية لاختيار النموذج الأمثل لمشروعك

Image credit: Created by artificialanalysis.ai

Image credit: Created by artificialanalysis.aiاختيار نموذج اللغة الكبير (LLM) – المعايير الأساسية ولوحات التصنيف

إن فهم ميزات وتسعير نماذج اللغة الكبيرة المختلفة ليس سوى الخطوة الأولى. السؤال الأهم هو: ما مدى كفاءتها الفعلية عند الاستخدام؟ تمامًا كما يخضع الطلاب للاختبارات لإثبات ما تعلّموه، تحتاج نماذج اللغة الكبيرة إلى اختبارات معيارية للتحقق من قدراتها بعد مرحلة التدريب. وهنا يأتي دور الاختبارات المعيارية (Benchmarks).

تتيح لنا هذه الاختبارات مقارنة النماذج في مهارات ومجالات متعددة. ولكن هناك نقطة مهمة: لا يوجد اختبار واحد يمنحنا الصورة الكاملة. فلكل مهمة احتياجات مختلفة، وقد لا يكون أفضل نموذج في المتوسط هو الأنسب لاحتياجاتك الخاصة. ولهذا، بالإضافة إلى المعايير، ننظر أيضًا إلى لوحات التصنيف (Leaderboards) التي تأخذ في الحسبان تفضيلات البشر في الاستخدام الفعلي.

مع ذلك، فإن المعايير المعيارية ليست معصومة من القصور. في بعض الأحيان، يتم "تدريب النماذج على الاختبار" بحيث تحقق نتائج مرتفعة لأنها حفظت الأنماط الخاصة بتلك الاختبارات، دون أن يكون ذلك دليلًا على فهم أعمق أو قدرة حقيقية على التعميم. لذا، قد تكون الاختبارات الأحدث، أو تلك التي تحتفظ بأسئلتها بشكل سري أو يتم تحديثها دوريًا، أكثر قدرة على تقديم نتائج واقعية ودقيقة.

كما أنه من الصعب قياس أداء النماذج في جميع المهام الواقعية؛ فقد تتطلب بعض الحالات مجموعات بيانات وأسئلة متخصصة في مجالات صناعية لا تتوفر بسهولة.

وعلى الرغم من هذه الملاحظات، تظل المعايير المعيارية من أفضل الأدوات المتاحة للمقارنة الموضوعية بين قدرات النماذج.

دعونا نستعرض أهم الاختبارات المعيارية المصنّفة وفقًا للقدرات التي تقيسها (حتى بداية عام 2025).

المعرفة العامة والاستدلال

تقيّم هذه المعايير مدى الفهم الواسع والقدرة على حل المشكلات في موضوعات متنوعة.

ملخص – معايير المعرفة العامة والاستدلال:

| الاختبار | التركيز / الغرض | مستوى الأداء العام (النماذج المتقدمة) | الحالة |

|---|---|---|---|

| MMLU | أسئلة اختيار من متعدد بمستوى جامعي في مجالات متعددة | دقة عالية جدًا | شبه مشبع |

| MMLU-Pro | نسخة أصعب من MMLU (10 خيارات مع تركيز على الاستدلال) | قوي لكنه أقل بكثير من الكمال | صعب |

| GPQA | أسئلة علمية بمستوى الدراسات العليا "مقاومة للبحث في جوجل" | أداء قوي لكن أقل بكثير من أداء الخبراء البشر | صعب |

| GPQA Diamond | أصعب مجموعة فرعية من GPQA | متوسط؛ حتى النماذج الرائدة تواجه صعوبة كبيرة | صعب جدًا |

| امتحان البشرية الأخير (HLE) | "الاختبار النهائي" الشامل في جميع المجالات | منخفض جدًا؛ يكشف فجوة هائلة مقارنة بخبرة البشر | غير محلول |

| SimpleQA | أسئلة قصيرة واقعية (لقياس الهلوسة) | مرتفع (خصوصًا مع الاسترجاع) ويقترب من التشبع | متوسط الصعوبة |

| ZeroEval (عام) | إطار موحّد لتقييم الاستدلال الصفري (يشمل MMLU-Redux) | يختلف حسب المهمة؛ النماذج الرائدة تؤدي جيدًا | إطار عمل |

MMLU (Massive Multitask Language Understanding): اختبار قياسي يغطي 57 مجالًا باستخدام أسئلة اختيار من متعدد بمستوى جامعي.

الحالة: النماذج المتقدمة تحقق دقة عالية جدًا، مما يشير إلى أن هذا الاختبار أصبح شبه مشبع للتمييز بين نماذج LLM الرائدة.

MMLU-Pro: نسخة أكثر صعوبة مع خيارات إجابة إضافية ومتطلبات استدلال أعمق.

الحالة: يميز بفعالية بين النماذج العليا التي تقدم أداءً قويًا، لكنها ما زالت بعيدة عن الكمال. يظل تحديًا قائمًا.

GPQA (Graduate-Level Google-Proof Q&A): يركز على أسئلة علمية معقدة لا يمكن الإجابة عنها بالبحث البسيط عبر الإنترنت.

الحالة: تقدم النماذج الرائدة أداءً جيدًا لكنها تظل أقل بكثير من مستوى الخبراء، ما يجعله اختبارًا صعبًا جدًا.

GPQA Diamond: مجموعة فرعية أصعب ضمن GPQA.

الحالة: حتى أفضل النماذج تواجه صعوبة كبيرة وتحقق نتائج متوسطة في أحسن الأحوال، مما يجعله اختبارًا شديد الصعوبة.

امتحان البشرية الأخير (HLE - Humanity’s Last Exam): صُمم كاختبار أكاديمي نهائي وشامل.

الحالة: الأداء الحالي للنماذج منخفض جدًا، ما يدل على وجود فجوة واسعة للوصول إلى مستوى الاستدلال الخبير. يعتبر غير محلول.

SimpleQA: يختبر دقة الإجابة على أسئلة قصيرة وواقعية لقياس ميل النماذج إلى الهلوسة.

الحالة: تحقق النماذج الرائدة وأنظمة الإجابة المتخصصة دقة مرتفعة، مما يجعله متوسط الصعوبة لكنه يقترب من التشبع.

ZeroEval: إطار لتقييم مهام الاستدلال الصفري مثل إصدارات MMLU.

الحالة: إطار عمل مفيد؛ يختلف الأداء باختلاف المهام الأساسية.

الاستدلال الرياضي

تختبر هذه المعايير قدرة النماذج على حل المسائل الرياضية.

ملخص – معايير الاستدلال الرياضي:

| الاختبار | التركيز / الغرض | مستوى الأداء العام (النماذج المتقدمة) | الحالة |

|---|---|---|---|

| MATH | مسائل رياضية بمستوى المسابقات (AMC/AIME) | دقة عالية جدًا (خصوصًا مع استخدام الأدوات) | شبه مشبع |

| MathVista | استدلال رياضي متعدد الوسائط (نص + رسومات) | مرتفع، يقترب / يتجاوز متوسط مستوى البشر | صعب |

| AIME | أسئلة مسابقات رياضيات صعبة بمستوى الثانوية | مرتفع جدًا (يعادل / يتجاوز الأبطال البشريين) | شبه مشبع |

| GSM8k | مسائل حسابية لغوية بمستوى الابتدائية | مرتفع جدًا (دقة شبه كاملة) | مشبع |

MATH (Massive Multitask Arithmetic): مسائل رياضية صعبة بمستوى المسابقات تتطلب استدلالًا متعدد الخطوات.

الحالة: النماذج الرائدة، وخاصة عند استخدام الأدوات أو توليد الشيفرات، تحقق دقة عالية جدًا وتقترب من مستوى الخبراء البشريين في العديد من المسائل. شبه مشبع.

MathVista: يقيّم القدرة على الاستدلال الرياضي والفهم البصري (المخططات والرسومات).

الحالة: النماذج متعددة الوسائط الرائدة تؤدي بشكل جيد، وتقترب أو تتجاوز الأداء البشري المتوسط، لكن الاستدلال البصري المعقد لا يزال يمثل تحديًا.

AIME (American Invitational Mathematics Examination): يستخدم مسائل من مسابقة مرموقة بمستوى المرحلة الثانوية.

الحالة: تحقق النماذج المتقدمة درجات عالية جدًا تعادل أو تتجاوز أفضل المتسابقين من البشر، ما يشير إلى شبه إتقان هذا المستوى. شبه مشبع (مع وجود مخاوف حول تلوث البيانات).

GSM8k: مسائل حسابية لغوية بمستوى التعليم الابتدائي تتطلب خطوات متعددة.

الحالة: حُلَّت بشكل شبه كامل بواسطة النماذج الرائدة، إذ تحقق دقة شبه مثالية. يُستخدم حاليًا كاختبار أساسي مرجعي.

القدرة على البرمجة

تقيّم هذه المعايير قدرة النماذج على توليد شيفرات صحيحة وفعّالة وحل المشكلات البرمجية.

ملخص – معايير القدرة على البرمجة:

| الاختبار | التركيز / الغرض | مستوى الأداء العام (النماذج المتقدمة) | الحالة |

|---|---|---|---|

| HumanEval | كتابة دوال بايثون أساسية (مؤشر pass@1) | مرتفع جدًا (نسبة نجاح شبه كاملة) | شبه مشبع |

| SWE-Bench | حل مشكلات حقيقية على GitHub (تعديلات متعددة الملفات) | متوسط إلى مرتفع؛ يحل الكثير لكن يفشل بشكل متكرر | صعب |

| LiveCodeBench | حل مسائل جديدة من مسابقات البرمجة (بدون تلوث بيانات) | مرتفع، لكنه يفشل باستمرار في جزء من المسائل الجديدة | صعب |

| Codeforces | برمجة تنافسية (تقييم Elo) | مرتفع جدًا (يعادل خبراء / كبار اللاعبين البشريين) | متقدم جدًا |

| Aider Polyglot | تعديل شيفرات في 6 لغات برمجية (تمارين صعبة) | قدرة قوية متعددة اللغات، مع تباين كبير في الأداء | صعب |

HumanEval: اختبار أساسي لكتابة دوال بايثون صحيحة.

الحالة: حُلَّ بشكل شبه كامل بواسطة النماذج الرائدة التي تحقق نسب نجاح شبه مثالية. شبه مشبع.

SWE-Bench: اختبار أكثر واقعية يعتمد على مشكلات حقيقية في GitHub غالبًا تتطلب تعديلات على ملفات متعددة.

الحالة: يظل تحديًا قائمًا؛ إذ تتمكن النماذج والأنظمة المتخصصة من حل نسبة كبيرة لكنها ما زالت تفشل بشكل متكرر، خاصة في المشكلات المعقدة.

LiveCodeBench: يستخدم مسائل برمجة جديدة ومحدثة باستمرار لتجنب تلوث البيانات.

الحالة: تحل النماذج الرائدة غالبية المسائل لكنها تفشل بانتظام في نسبة ملحوظة من المشكلات الجديدة. ما زال اختبارًا صعبًا ويعطي مؤشرًا جيدًا على قدرة التعميم.

Codeforces: يقيس الأداء في مسائل البرمجة التنافسية بناءً على تصنيف Elo.

الحالة: تحقق النماذج المتقدمة الآن تصنيفات تعادل مستويات الخبراء البشريين، ما يمثل قدرة رائدة.

Aider Polyglot: يختبر القدرة على تعديل الشيفرات في عدة لغات باستخدام تمارين معقدة.

الحالة: تظهر النماذج الرائدة قدرة قوية في التعديل متعدد اللغات، لكن مع تباين كبير بين النماذج. يظل تحديًا قائمًا.

الاستدلال المنطقي

يقيّم هذا النوع من المعايير القدرة على الاستنتاج المنطقي البحت، وغالبًا باستخدام الألغاز.

ملخص – معايير الاستدلال المنطقي:

| الاختبار | التركيز / الغرض | مستوى الأداء العام (النماذج المتقدمة) | الحالة |

|---|---|---|---|

| ZebraLogic | ألغاز الجداول المنطقية (حل قيود متشابكة) | منخفض؛ ما تزال هناك قيود كبيرة | صعب |

| EQ-Bench | الذكاء العاطفي في الحوارات | مرتفع؛ يرتبط بقوة بالكفاءة العامة | متوسط |

ZebraLogic (عبر ZeroEval): يعتمد على ألغاز الجداول المنطقية الكلاسيكية.

الحالة: ما زال تحديًا صعبًا جدًا للنماذج اللغوية الكبيرة؛ حتى أفضل النماذج تنجح في حل نسبة محدودة فقط، مما يكشف عن قيود واضحة في القدرة على الاستنتاج المنطقي البحت.

EQ-Bench: يقيس الذكاء العاطفي من خلال تحليل الحوارات أو مهام الوساطة والتفاوض.

الحالة: تعرض النماذج الحوارية الرائدة أداءً مرتفعًا يرتبط بقوة بمستوى الكفاءة العامة، ويعد تحديًا متوسط الصعوبة في الوقت الحالي.

الفهم متعدد الوسائط

يتطلب هذا النوع من المعايير معالجة المعلومات من الصور أو المخططات أو الوثائق إلى جانب النصوص.

ملخص – معايير الفهم متعدد الوسائط:

| الاختبار | التركيز / الغرض | مستوى الأداء العام (النماذج المتقدمة) | الحالة |

|---|---|---|---|

| MMMU | أسئلة جامعية متعددة الوسائط (نص + صور متنوعة) | متوسط؛ أقل بكثير من مستوى الخبراء البشر | صعب |

| ChartQA | أسئلة حول المخططات والرسوم البيانية | دقة عالية، لكن المخططات المعقدة تظل صعبة | متوسط الصعوبة |

| DocVQA | أسئلة على صور الوثائق (النص والتخطيط) | مرتفع جدًا (دقة شبه بشرية) | شبه مشبع |

| Vibe-Eval | أسئلة حوارية مفتوحة على الصور (تشمل أسئلة صعبة) | أداء قوي إجمالًا مع صعوبة واضحة في الأسئلة الأصعب | صعب |

MMMU (Massive Multi-discipline Multimodal Understanding): أسئلة بمستوى جامعي تجمع بين النصوص وصور متنوعة.

الحالة: يظل تحديًا كبيرًا، إذ إن أداء النماذج الرائدة ما يزال أقل بكثير من مستوى الخبراء البشريين.

ChartQA: يركز على فهم البيانات والتفسير المنطقي للمعلومات المعروضة في المخططات والرسوم البيانية.

الحالة: تحقق النماذج المتقدمة دقة عالية لكنها تواجه صعوبة عند التعامل مع المخططات المعقدة. متوسط الصعوبة.

DocVQA: أسئلة حول صور الوثائق تجمع بين قراءة النص والتخطيط البصري.

الحالة: تحقق النماذج الرائدة دقة شبه بشرية، مما يشير إلى أن هذا المجال شبه مشبع بالنسبة لمهام قراءة النص والتخطيط الأساسي.

Vibe-Eval: أسئلة حوارية مفتوحة حول الصور، بما في ذلك أسئلة صعبة ومعقدة.

الحالة: تعرض النماذج المتقدمة متعددة الوسائط أداءً قويًا بشكل عام لكنها تواجه صعوبة واضحة في أكثر الأسئلة تعقيدًا، مما يجعله اختبارًا صعبًا.

اتباع التعليمات والمهام الواقعية

يقيّم هذا النوع من المعايير الأداء العملي للنماذج في مهام متنوعة وغالبًا جديدة.

ملخص – معايير اتباع التعليمات والمهام الواقعية:

| الاختبار | التركيز / الغرض | مستوى الأداء العام (النماذج المتقدمة) | الحالة |

|---|---|---|---|

| LiveBench | مهام ديناميكية خالية من التلوث (يُفترض تحديثها شهريًا) | أداء قوي في مختلف المجالات | صعب |

| Fiction.liveBench | فهم سردي عميق لنصوص طويلة جدًا | يختلف بشدة حسب طول نافذة السياق | صعب |

| ZeroEval (مهام محددة) | تقييم صفري موحّد لمهام استدلال محددة (مثل GSM8k، CRUX) | أداء قوي للنماذج الرائدة | إطار عمل |

LiveBench: يعتمد على مهام واقعية محدّثة باستمرار في مجالات متعددة لتجنب تلوث البيانات.

الحالة: معيار موثوق وصعب؛ تحقق النماذج العامة الرائدة أداءً قويًا وثابتًا عبر مختلف المهام.

Fiction.liveBench: يختبر الفهم العميق للنصوص السردية الطويلة جدًا.

الحالة: يعتمد الأداء بدرجة كبيرة على حجم نافذة السياق لدى النموذج؛ النماذج التي تدعم سياقًا ضخمًا تتفوّق، بينما تواجه النماذج الأخرى صعوبة واضحة. يظل تحديًا للفهم العميق.

ZeroEval (المهام المحددة): يوفر إطارًا موحّدًا للتقييم الصفري عبر مجموعة كبيرة من مهام الاستدلال المحددة.

الحالة: إطار عمل مفيد؛ مستوى الأداء يختلف بحسب المهمة الأساسية محل التقييم.

القدرات متعددة اللغات

يقيّم هذا النوع من المعايير أداء النماذج عبر لغات مختلفة.

ملخص – معايير القدرات متعددة اللغات:

| الاختبار | التركيز / الغرض | مستوى الأداء العام (النماذج المتقدمة) | الحالة |

|---|---|---|---|

| MMMLU | ترجمة مهام MMLU إلى 14 لغة | أداء قوي وقدرة جيدة على التعميم | متوسط الصعوبة |

| MTOP | التحليل الدلالي للحوار الموجّه للمهام بـ6 لغات | أداء قوي للنماذج الرائدة | متوسط |

| MGSM | مسائل رياضيات ابتدائية مترجمة إلى 10 لغات متنوعة | دقة عالية جدًا (قريبة من التشبع) | شبه مشبع |

| Global MMLU | تحسين الإنصاف الثقافي في MMLU عبر 42 لغة | تركيز على التقييم العادل (النتائج قيد التطور) | مرحلة مبكرة؛ النتائج تتطور |

Multilingual MMLU (MMMLU): اختبار MMLU بعد ترجمته إلى 14 لغة مختلفة.

الحالة: تعرض النماذج الرائدة أداءً قويًا يدل على قدرة جيدة على التعميم متعدد اللغات. متوسط الصعوبة.

MTOP: تحليل دلالي للحوار الموجّه للمهام في ست لغات.

الحالة: تحقق النماذج الرائدة أداءً جيدًا. يعتبر ذا صعوبة متوسطة.

MGSM (Multilingual GSM8k): مسائل رياضيات ابتدائية مترجمة إلى عشر لغات متنوعة.

الحالة: تحقق النماذج المتقدمة دقة عالية جدًا تقترب من التشبع، وإن كانت الدقة تنخفض قليلًا في اللغات غير الإنجليزية. شبه مشبع.

Global MMLU: يهدف إلى تحسين الإنصاف الثقافي مقارنةً بـMMLU الأصلي عبر 42 لغة.

الحالة: ما يزال في مرحلة مبكرة، والنتائج قيد التطور مع تقدم النماذج وأساليب التقييم عبر اللغات المختلفة.

تقييم السياق الطويل

يختبر هذا النوع من المعايير قدرة النماذج على معالجة واستيعاب مدخلات طويلة جدًا.

ملخص – معايير تقييم السياق الطويل:

| الاختبار | التركيز / الغرض | مستوى الأداء العام (النماذج المتقدمة) | الحالة |

|---|---|---|---|

| Fiction.liveBench | فهم سردي عميق للقصص الطويلة جدًا | الأداء يرتبط بشدة بحجم نافذة السياق | صعب |

| SCBENCH | كفاءة معالجة السياق الطويل (استخدام ذاكرة KV) | يختلف حسب بنية النموذج والتقنية | قيد التطوير |

| Michelangelo / MRCR | استدلال طويل السياق عبر النصوص/الشيفرات | معيار حديث يهدف لدفع حدود القدرات | صعب |

Fiction.liveBench: يختبر الفهم العميق للنصوص السردية الطويلة جدًا.

الحالة: يرتبط الأداء بقوة بحجم نافذة السياق لدى النموذج؛ ما يجعله تحديًا كبيرًا للنماذج التي لا تدعم سياقًا ضخمًا.

SCBENCH: يركز على الكفاءة التقنية لمعالجة سياق طويل، خاصةً في كيفية استخدام ذاكرة المفاتيح والقيم (KV Cache).

الحالة: تختلف النتائج بناءً على بنية النموذج وتقنياته، وما يزال هذا المجال قيد البحث والتطوير.

Michelangelo Benchmark: معيار حديث مصمم لاختبار قدرات الاستدلال طويل السياق بشكل صارم.

الحالة: يهدف إلى دفع حدود قدرات النماذج الحالية، ومن المتوقع أن يكون اختبارًا صعبًا للغاية.

⚠️ لمحة عامة مهمة

هذه مجرد لمحة عامة. هناك العديد من المعايير المتخصصة أو الموجهة لصناعات محددة (رغم أنها غالبًا لا يتم تحديثها بانتظام). إذا كنت بحاجة إلى الذكاء الاصطناعي لمهمة تخصصية (مثل تحليل المستندات القانونية أو دعم تشخيص الأمراض)، فإن استخدام أدوات البحث المدعومة بالذكاء الاصطناعي أو وكلاء البحث المتقدم يمكن أن يساعدك في العثور على معايير أكثر ملاءمة تمنحك رؤى دقيقة حول الأداء.

الاستخلاص العملي حول المعايير المعيارية

لا داعي لحفظ جميع هذه الأسماء! المهم أن تستوعب الأفكار الرئيسية:

- الاختبارات المعيارية تقيس مهارات محددة: تأكد من فهم ما يقيسه كل اختبار (مثل البرمجة مقابل الرياضيات مقابل المعرفة العامة مقابل الفهم متعدد الوسائط).

- طابق المعايير مع احتياجاتك:

إذا كان مشروعك يعتمد بشكل أساسي على مساعدة الذكاء الاصطناعي في البرمجة، راقب نتائج HumanEval أو SWE-Bench أو LiveCodeBench.

إذا كنت تحلل تقارير تحتوي على رسوم بيانية، ركز على MMMU أو ChartQA.

أما إذا كانت القدرة على حل المشكلات المعقدة جوهرية، فراجع معايير الاستدلال مثل GPQA أو MATH. - انتبه إلى التشبع:

إذا كانت جميع النماذج الرائدة تسجل نتائج شبه مثالية في اختبار معين (مثل GSM8k)، يصبح هذا المعيار أقل فائدة في التمييز بين الأفضل.

أما المعايير الأصعب (مثل HLE وGPQA Diamond وSWE-Bench) فهي أكثر قدرة على الكشف عن إمكانات النماذج الرائدة فعلًا.

لوحات تصنيف نماذج اللغة الكبيرة (LLM Leaderboards)

بينما تقيس المعايير المعيارية القدرات التقنية الصرفة، فإن لوحات التصنيف عادةً ما تدمج تقييمات البشر وعوامل الاستخدام الواقعي. وهي تمنحك نظرة مهمة حول مدى فائدة النماذج ومدى ترابطها أو تفضيلها من قبل المستخدمين الفعليين أثناء التفاعل. وتكتسب هذه الرؤية أهمية خاصة في المهام التي تعتمد على التواصل أو الإبداع أو التعاون.

كما أن بعض لوحات التصنيف تجمع نتائج اختبارات معيارية متعددة، لتوفر صورة شاملة حول أداء النماذج في المجالات الرئيسية المختلفة.

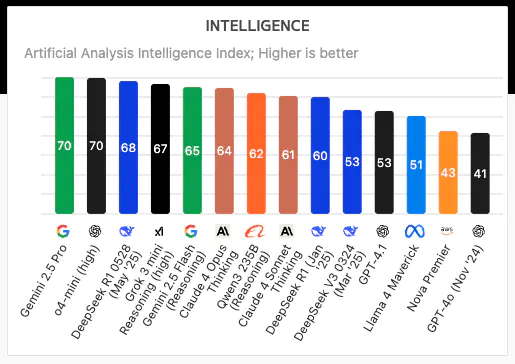

Artificial Analysis

موقع Artificial Analysis يوفر لوحات تصنيف ترتب نماذج اللغة الكبيرة وفقًا لمؤشرات متعددة مثل الجودة، وسرعة الإخراج (الرموز في الثانية)، والكمون (Latency)، والسعر، وحجم نافذة السياق، ما يمنحك تصورًا شاملًا للأداء.

يقوم الموقع بإجراء اختبارات مستقلة لقياس قدرات الاستدلال للنماذج المقدمة عبر واجهات برمجة التطبيقات الخالية من الخوادم (Serverless API).

- تقييم الجودة: يستند إلى نتائج اختبارات MMLU وGPQA وMATH وHumanEval وMGSM.

- تقييم الأداء: يركز على تجربة المستخدم الواقعية؛ إذ تعكس الاختبارات الأداء العملي عبر مختلف المزودين. تشمل سيناريوهات الأداء قياس طول مدخلات الطلبات وأحمال العمل المختلفة لمعرفة سرعة الإخراج (الرموز في الثانية) والكمون. يتم استخدام طلبات إدخال بأطوال متفاوتة (حوالي 100، و1,000، و10,000 رمز) لقياس الأداء في سيناريوهات الطلب الفردي والطلبات المتوازية. عادةً ما تؤدي الطلبات الأطول إلى زيادة الوقت اللازم لاستلام أول رمز وتباطؤ سرعة الإخراج. ويحرص الموقع على استخدام طلبات فريدة لكل اختبار لضمان الحصول على نتائج شاملة ومحدثة باستمرار.

LMSYS Chatbot Arena

يُعَدّ LMSYS Chatbot Arena منصة مفتوحة قائمة على المساهمات الجماعية لتقييم نماذج اللغة الكبيرة. تعتمد المنصة على مقارنات بشرية ثنائية (Pairwise Comparisons) لترتيب النماذج باستخدام نموذج Bradley-Terry (طريقة تحسين التفضيلات المباشرة)، حيث يتفاعل المستخدمون مع نموذجين مجهولين ويصوتون للاستجابة الأفضل.

يتم تجميع هذه الأصوات وتصنيف النماذج وفق نظام Elo للتصنيف، وهو نفس النظام المستخدم في تصنيف لاعبي الشطرنج. وتُعَدّ هذه المنصة من بين القلائل التي تستند إلى تفضيلات المستخدمين الفعليين بدلاً من الاكتفاء بالأسئلة الاختبارية المحددة مسبقًا، ما يمنحها قيمة خاصة في تقييم الجودة الحقيقية للنماذج أثناء الاستخدام الواقعي.

Scale SEAL Leaderboard

تقدم شركة Scale لوحة تصنيف SEAL Leaderboard، التي ترتب نماذج اللغة الكبيرة باستخدام مجموعات بيانات خاصة لضمان تقييم النماذج على بيانات غير معروفة فعليًا وتجنب مشكلات تلوث البيانات.

تقيّم هذه اللوحة الأداء في أربعة مجالات رئيسية:

- البرمجة: يشمل 1,000 مهمة برمجية تغطي لغات ومجالات متنوعة.

- اتباع التعليمات: يعتمد على مجموعة بيانات مكونة من 1,054 طلبًا دقيقًا تقيس قدرة النماذج على تفسير الأوامر التفصيلية وتنفيذها.

- الرياضيات: يستند إلى مجموعة بيانات GSM1k التي تحتوي على مسائل رياضيات بمستوى امتحانات الصف الخامس، لقياس مهارات الاستدلال العددي.

- القدرات متعددة اللغات: يضم 1,000 طلب لكل لغة بهدف اختبار فعالية النماذج عبر سياقات لغوية متنوعة.

من خلال الحفاظ على خصوصية مجموعات البيانات، يقدّم SEAL مقياسًا أكثر موثوقية لقدرات التعميم والقدرة على حل المشكلات الواقعية.

الاستخلاص العملي حول المعايير

لا داعي لحفظ جميع الأسماء! الأهم هو فهم النقاط التالية:

- كل اختبار يقيس مهارات محددة.

- طابق المعايير مع احتياجات مشروعك.

- انتبه إلى معايير "التشبع" التي لم تعد تميز بين النماذج.

اختيار نموذج اللغة الكبير (LLM): اعتبارات أساسية

أنواع النماذج

- النماذج المملوكة (مثل GPT-4، Claude)

- النماذج مفتوحة الأوزان (مثل Llama، Mixtral)

- النماذج مفتوحة المصدر (مثل OLMo، Pynthia)

- المفاضلات: الأداء مقابل إمكانية التخصيص

العوامل التقنية الرئيسية

- زمن الاستجابة (زمن الحصول على أول رمز)

- طول السياق

- كفاءة الترميز

- تغطية المفردات

- القدرات متعددة الوسائط

- خيارات التخصيص (Fine-tuning)

- اختبارات الأداء المعيارية

- متطلبات الذاكرة

- سرعة الاستدلال

- موثوقية واجهة البرمجة (API)

العوامل المتعلقة بالتكلفة

- تكلفة الرمز تختلف بشكل كبير

- تسعير الرموز المدخلة مقابل الرموز المخرجة

- استهلاك وحدات GPU عند التشغيل الذاتي

- نفقات التخصيص (Fine-tuning)

أهم الاختبارات المعيارية

- MMLU (يشمل 57 مجالًا)

- MMLU Pro

- HumanEval (البرمجة)

- GPQA (المعرفة المتخصصة)

- LiveBench (خالية من التلوث)

- ZeroEval (إطار موحّد)

أفضل لوحات التصنيف

- Artificial Analysis

- LMSYS Chatbot Arena

- Scale SEAL

تتطلب عملية اختيار النموذج تحقيق توازن بين الأداء والتكلفة ومتطلبات حالات الاستخدام المحددة.

الخاتمة

في هذا الدرس، استعرضنا كيفية قياس أداء نماذج اللغة الكبيرة، بدءًا من الاختبارات المعيارية القياسية ووصولًا إلى لوحات التصنيف المعتمدة على تقييمات المستخدمين. توفر المعايير المعيارية مقارنات منظمة، لكنها ليست خالية من القيود؛ إذ قد تؤدي أحيانًا إلى تحسين النماذج لزيادة الدرجات في الاختبارات على حساب تنوع القدرات في الاستخدامات الواقعية.

وتذكر دائمًا أن أداء نماذج اللغة الكبيرة هدف متحرك ومتغير باستمرار؛ فقد يكون النموذج المتصدر اليوم أقل تفوقًا غدًا أو في الشهر القادم. لذلك، من الضروري البقاء على اطلاع دائم بمستجدات الاختبارات المعيارية ولوحات التصنيف والتجارب الواقعية!